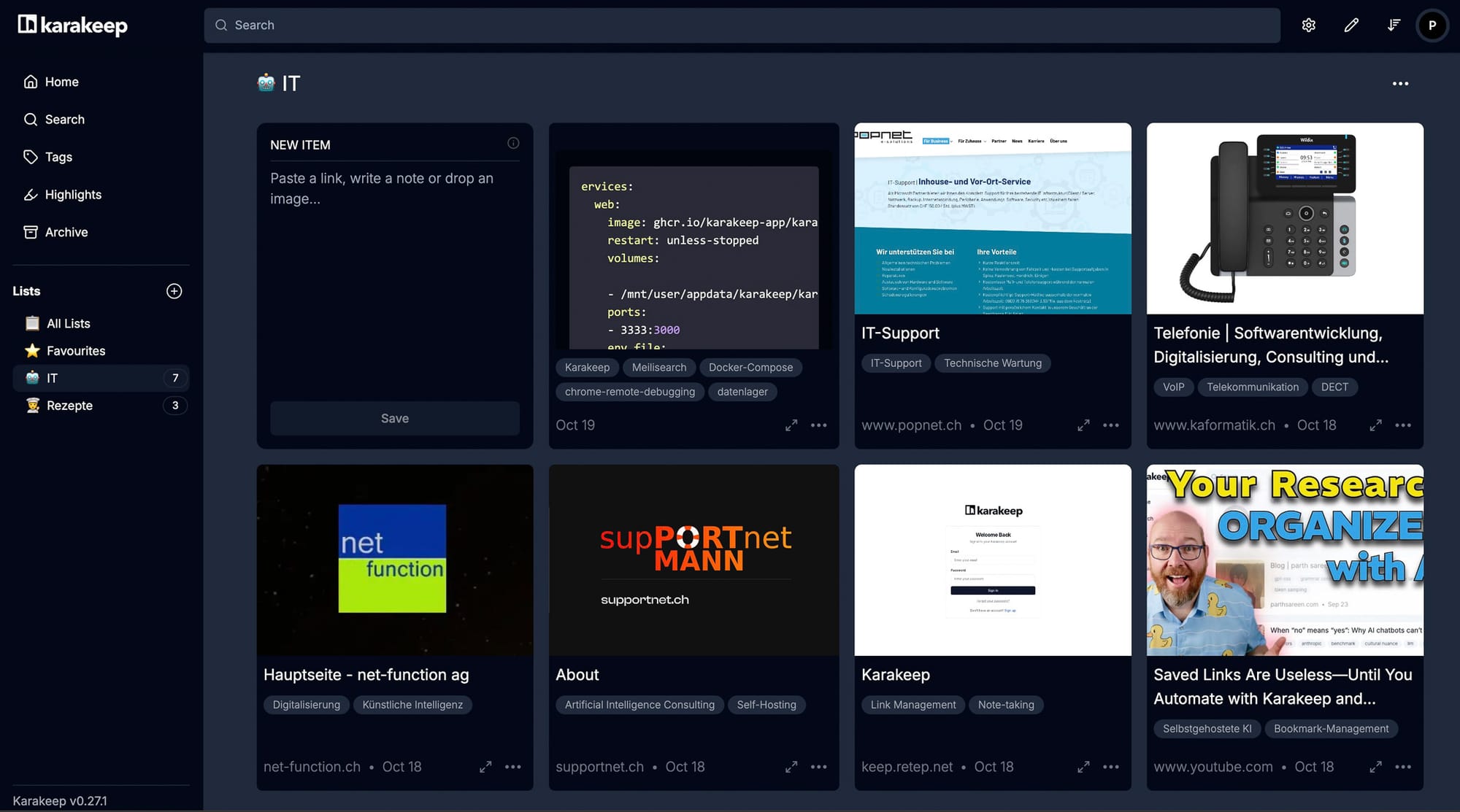

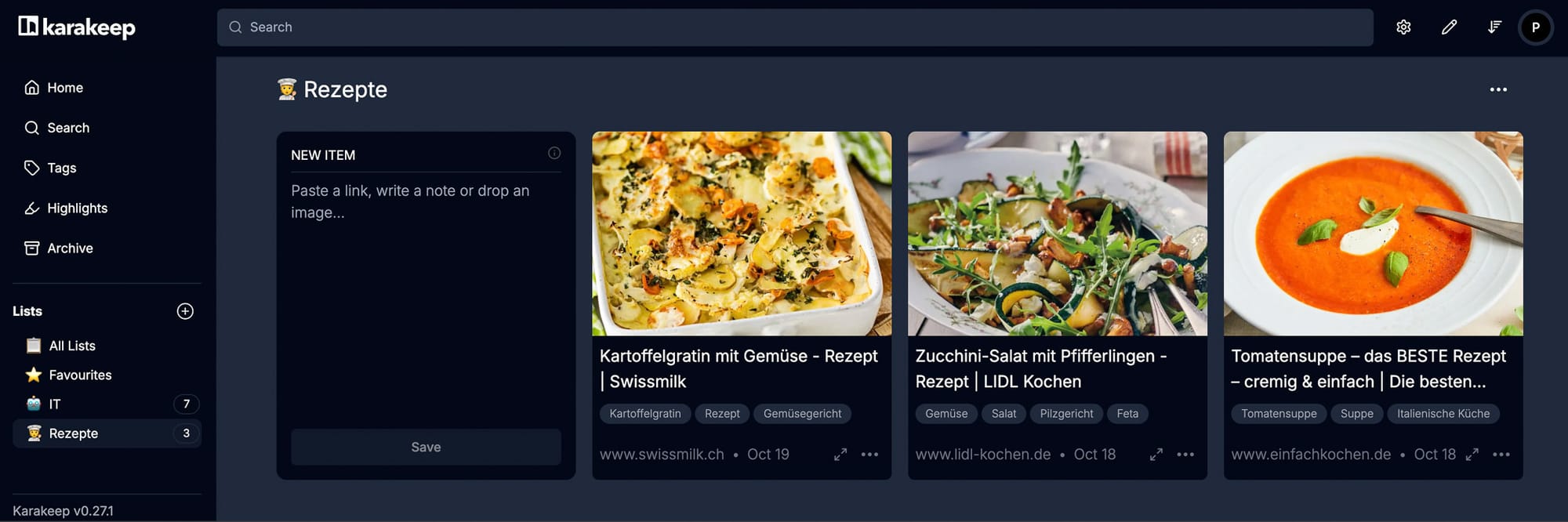

Ich bin bei weitem der aktivste Sammler. Es ist für mich eine Art Content-Management-System. Neben Internetadressen können auch Notizen, Fotos, Markdown-Dateien und pdfs gesichert und verwaltet werden. Genial ist die Möglichkeit, Listen zu erstellen und diese mit einem link zu teilen. Unter iOS verwende ich die Karakeep App, funktioniert auch schnell und effizient.

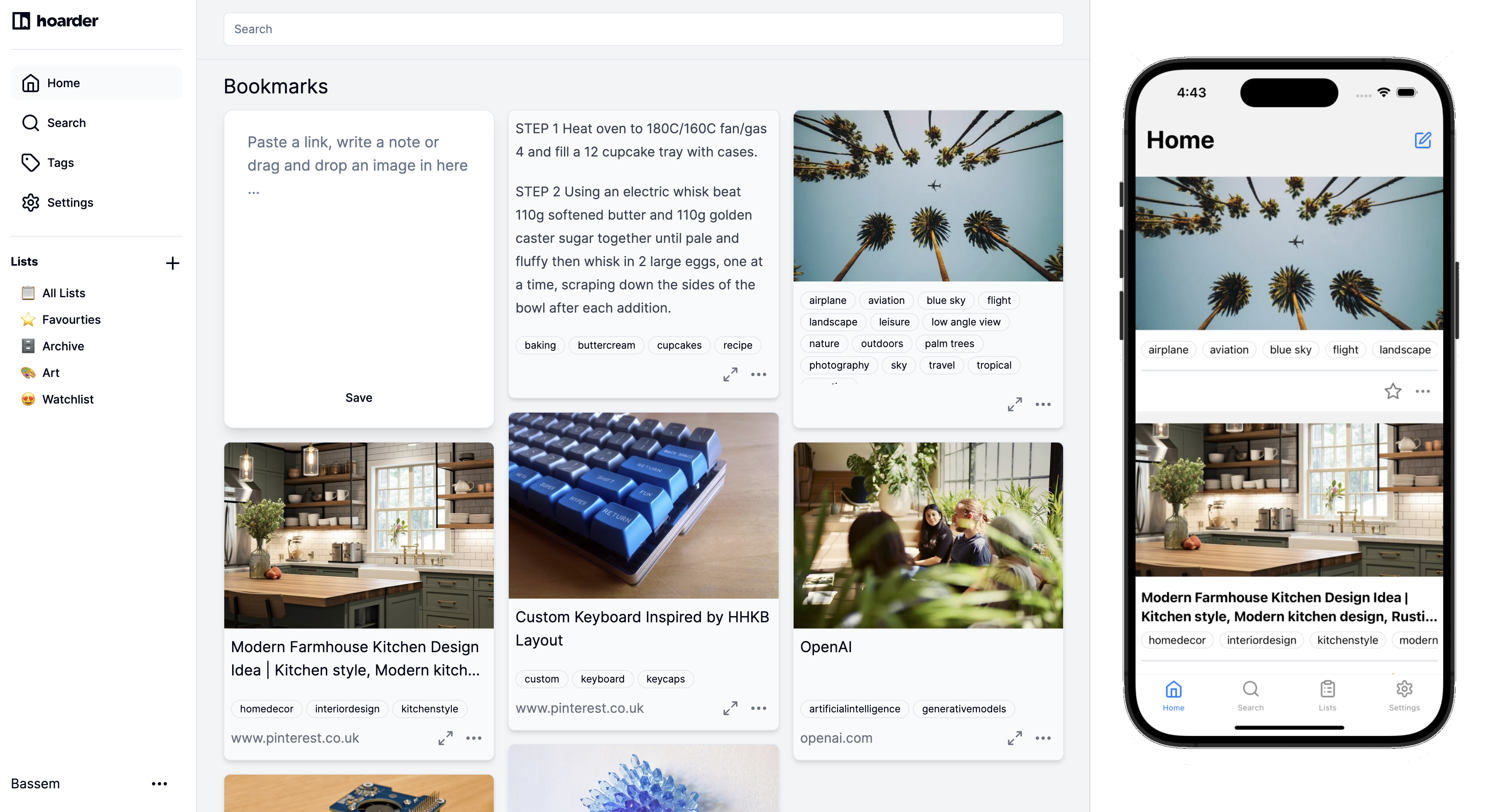

Schon länger beobachte ich das Projekt 'karakeep', früher 'hoarder' genannt. Aktuell verwende ich es als Spielwiese für KI‑Automation mit verschiedenen Instanzen wie Ollama und n8n auf UNRAID und einem macOS‑Server.

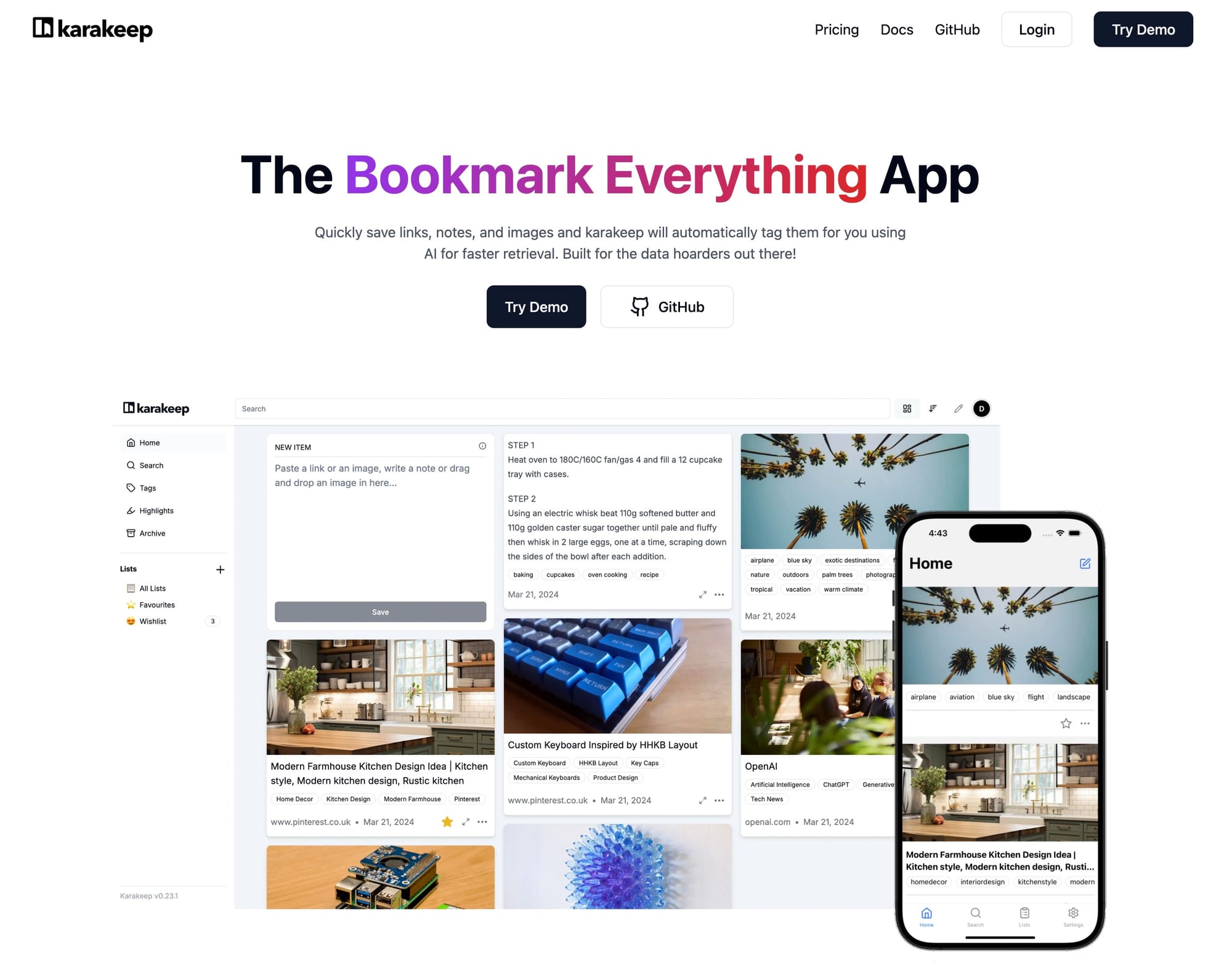

Was ist karakeep?

Link: Info

Schnell Links, Notizen und Bilder speichern. karakeep wird diese mithilfe von KI automatisch mit Schlüsselwörtern versehen, um einen schnelleren Zugriff zu ermöglichen. Entwickelt für die Daten-Sammler da draussen!

Link: Demo

Link: Apps für iOS und Android

Link: Code

Anwendung

karakeep ist nicht so flexibel wie ein Workflow mit 'Obsidian Web Clipper' und dem 'AI Tagger Universe' Plugin in Obsidian. Aber für einfache Aufgaben wie eine Rezeptesammlung passt es wohl besser.

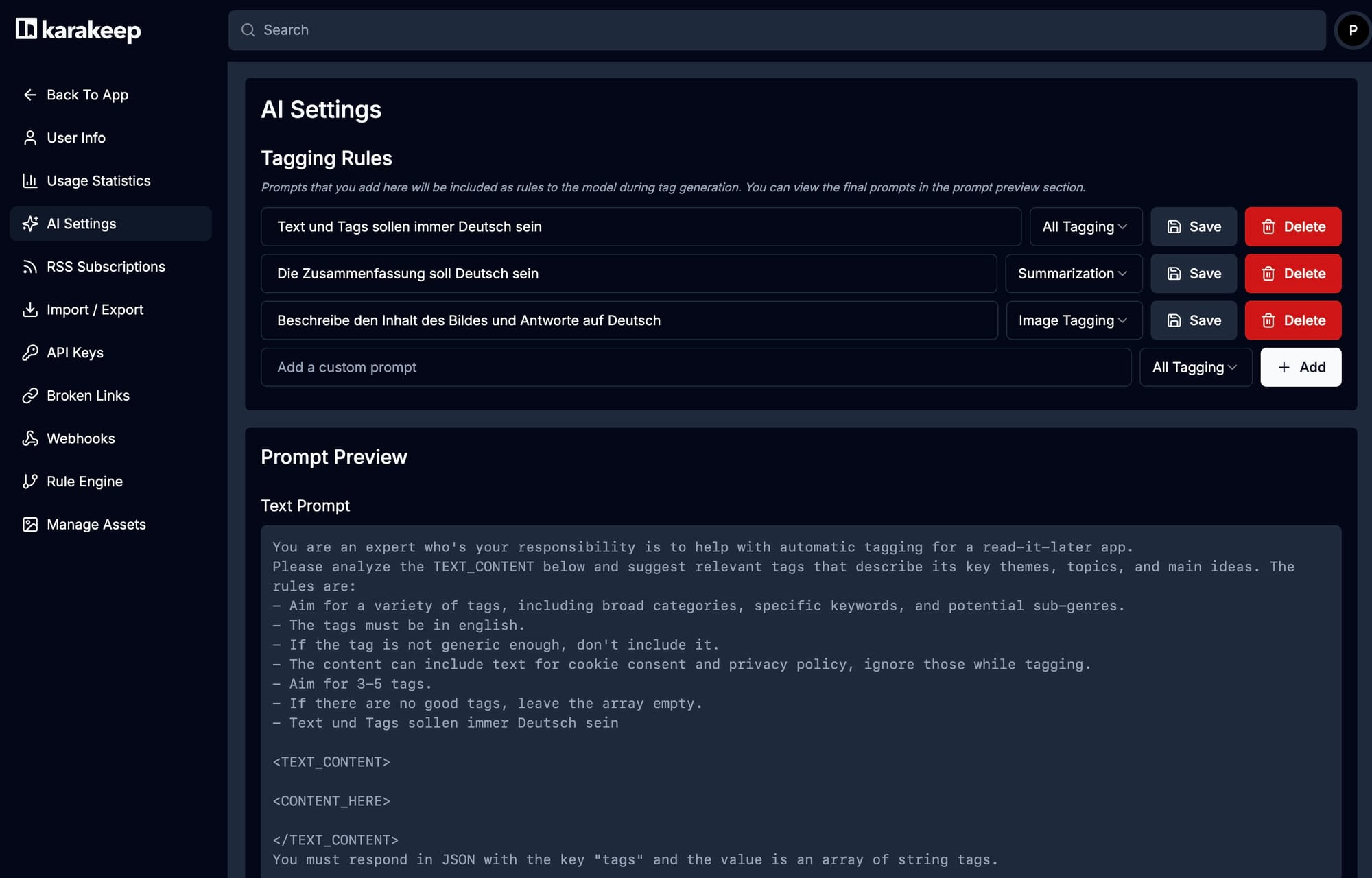

Konfiguration

In karakeep können die Prompts nur ergänzt und nicht ersetzt werden. Daher ist eine Automatisierung mit n8n geplant, damit die Prompts frei gestalten werden können.

Ich habe die Einstellungen angepasst, damit die Schlüsselwörter auf Deutsch formuliert werden. Dies muss für jeden Benutzer einzeln konfiguriert werden.

Internetadresse speichern

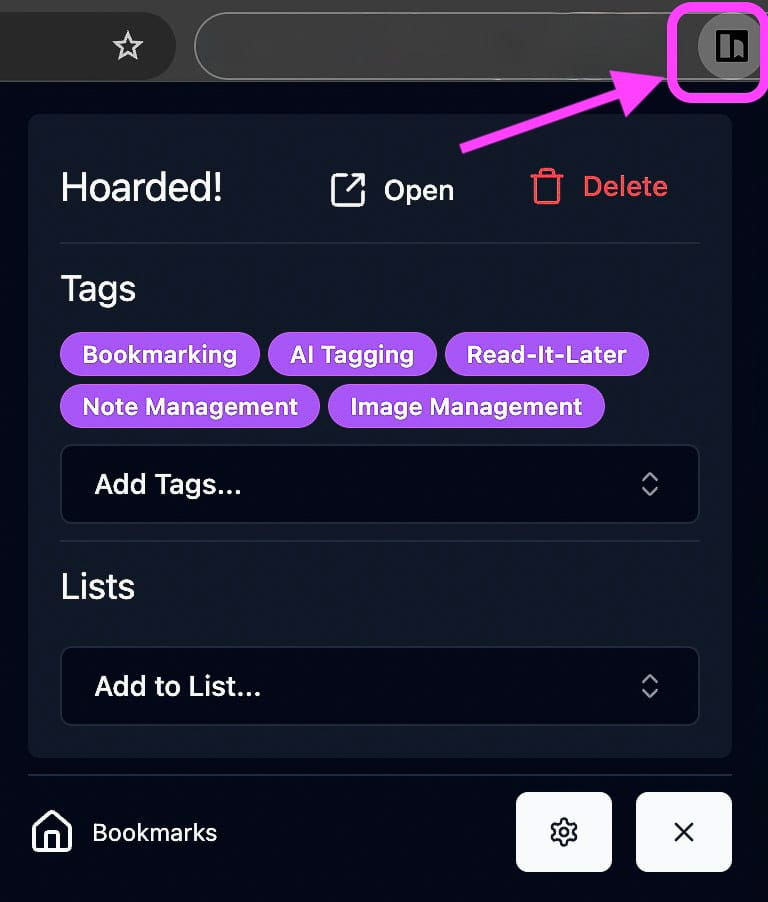

Chrome-Erweiterung

Im Chrome-Browser gibt es eine karakeep-Erweiterung. Eine Webseite kann so mit einem Klick in die karakeep-Sammlung gesichert werden.

Es sind verschiedene Komponenten beteiligt. Ein Webcrawler durchsucht zuerst die Website. Dann werden die Daten einer KI übergeben, welche den Inhalt untersucht und Schlüsselwörter sowie eine Zusammenfassung erstellt. Das dauert einen Moment.

Organisation

Die Webseiten können nach Tags/Schlüsselwörtern und Listen organisiert werden. Die Suchfunktion ist sehr schnell.

Installation

Es gibt diverse Möglichkeiten zur Installation [karakeep Dokumentation]. Ich verwende hier Docker. Unter UNRAID benötigt es einige Kniffe. Vielleicht hilft dieser Installationsweg jemandem weiter. Zurzeit läuft es produktiv für mich und meine Familie. Die Erweiterung mit n8n funktioniert noch nicht so, wie es sein soll, da bleibe ich dran.

UNRAID

UNRAID kann nativ keine Docker‑Stacks installieren. Die Container werden normalerweise einzeln konfiguriert und dann verknüpft. Hier habe ich das 'Compose Manager'‑Plugin verwendet. Dort funktioniert es mit einem docker‑compose.yaml und einem .env‑Bereich wie bei docker compose auch.

Bei mir sind die Dienste via Cloudflare‑Tunnel und einem Nginx‑Reverse‑Proxy erreichbar. So habe ich von überall aus Zugriff.

docker-compose.yaml

services:

web:

image: ghcr.io/karakeep-app/karakeep:${KARAKEEP_VERSION:-release}

restart: unless-stopped

volumes:

- /mnt/user/appdata/karakeep/karakeep_data/data:/data

ports:

- 3333:3000

env_file:

- .env

environment:

MEILI_ADDR: http://meilisearch:7700

BROWSER_WEB_URL: http://chrome:9222

DATA_DIR: /data

chrome:

image: gcr.io/zenika-hub/alpine-chrome:124

restart: unless-stopped

command:

- --no-sandbox

- --disable-gpu

- --disable-dev-shm-usage

- --remote-debugging-address=0.0.0.0

- --remote-debugging-port=9222

- --hide-scrollbars

meilisearch:

image: getmeili/meilisearch:v1.13.3

restart: unless-stopped

env_file:

- .env

environment:

MEILI_NO_ANALYTICS: "true"

volumes:

- /mnt/user/appdata/karakeep/meili_data:/meili_data

volumes:

meilisearch:

data:.env

Ollama Server: 192.168.16.45

UNRAID Server: 192.168.16.44MEILI_MASTER_KEY und NEXTAUTH_SECRET müssen mit openssl rand -base64 36 erzeugt werdenNEXTAUTH_URL=eigene Website

DATA_DIR=/data

MEILI_ADDR=http://192.168.16.44:7700

MEILI_MASTER_KEY=<openssl rand -base64 36 | tr -dc 'A-Za-z0-9'>

NEXTAUTH_URL=https://kara.supercool.net

NEXTAUTH_SECRET=<openssl rand -base64 36>

OLLAMA_BASE_URL=http://192.168.16.45:11434

INFERENCE_TEXT_MODEL=gpt-oss:20b

INFERENCE_IMAGE_MODEL=llava:13b

EMBEDDING_TEXT_MODEL=embeddinggemma:latest

INFERENCE_CONTEXT_LENGTH=8096

INFERENCE_ENABLE_AUTO_TAGGING=true

INFERENCE_ENABLE_AUTO_SUMMARIZATION=true

INFERENCE_JOB_TIMEOUT_SEC=60

INFERENCE_OUTPUT_SCHEMA=structuredIch freue mich auf Fragen und spannende Diskussionen.

Quellen

27.2.2205

01.10.2025

17.10.2025