Open WebUI: Kostenlose KI-Modelle via OpenRouter oder Ollama Cloud

Achtung: Die Daten gelangen dabei in die Cloud auf fremde Server im Ausland. Für sensible Personendaten ist das keine gute Idee. Zudem ist in den meisten Fällen auch unzulässig, wie privatim, die Konferenz der schweizerischen Datenschutzbeauftragten, in der [Resolution vom 24.11.2025] festhält.

Für Tests und anonyme Daten ist das beschriebene Vorgehen eher unbedenklich.

Lokaler Ollama-Server

Die Installation des Servers ist hier beschrieben:

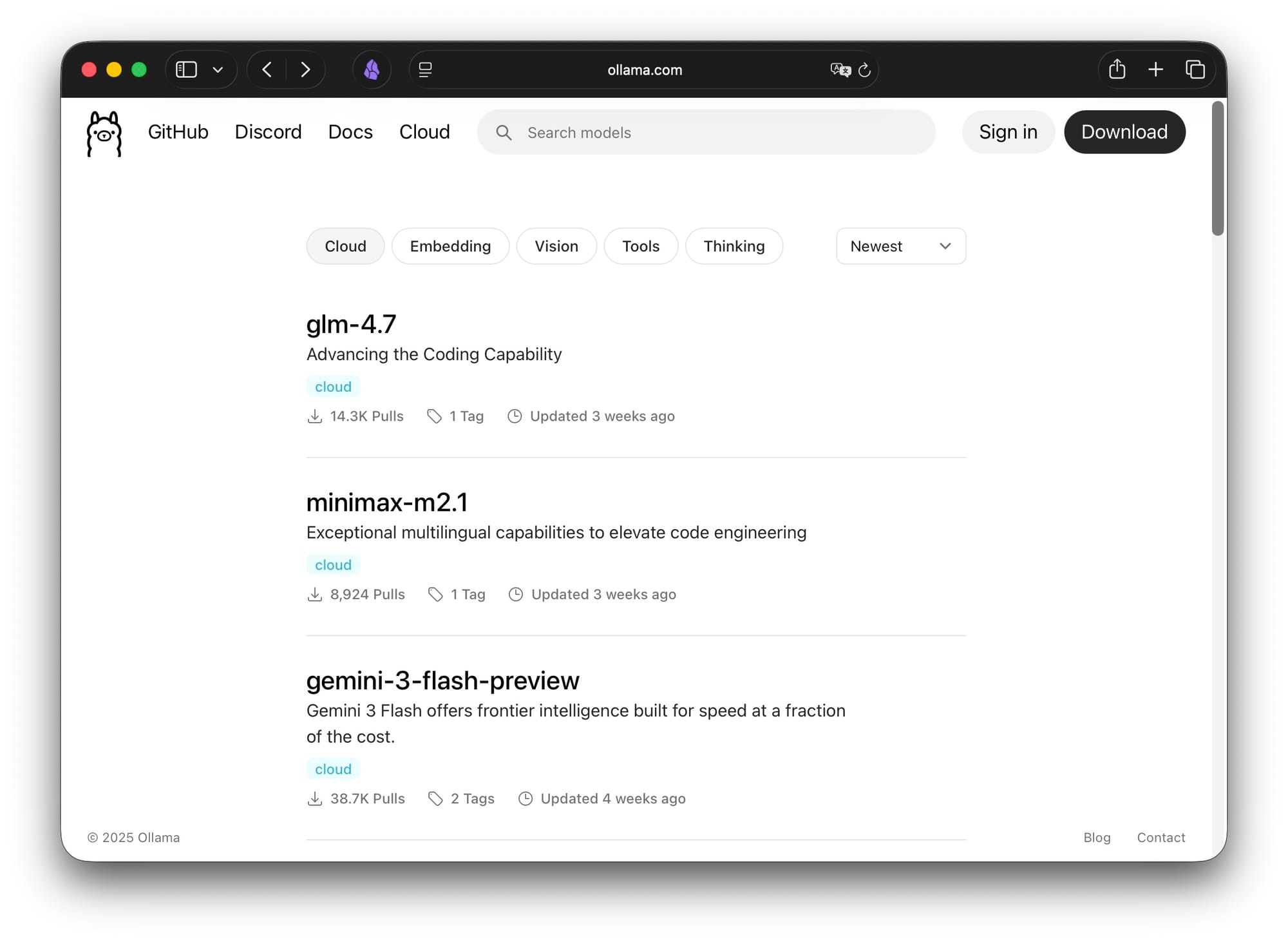

Ollama Cloud Modelle

Verfügbare Modelle können so angezeigt werden:

https://ollama.com/search?c=cloud

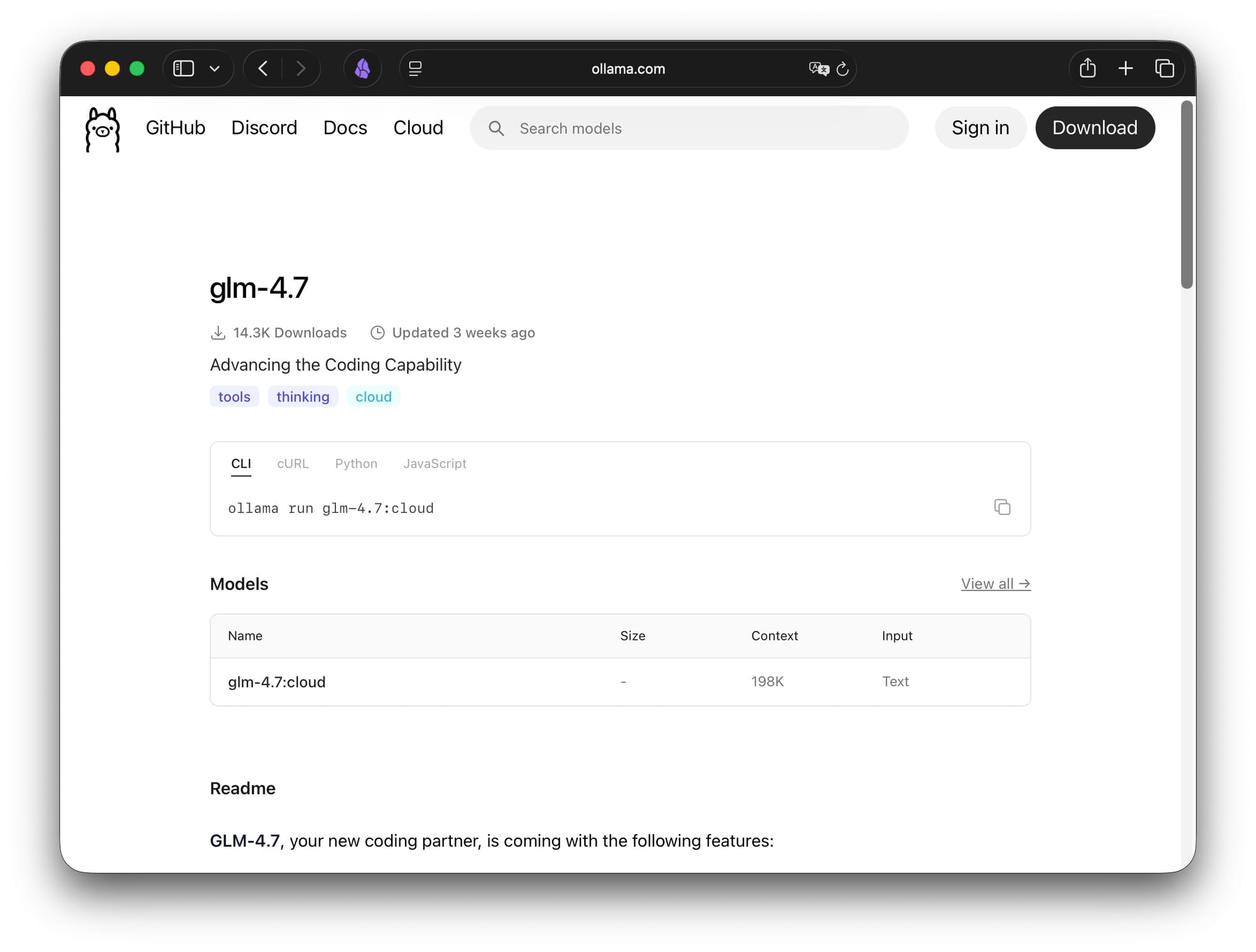

Die Bereitstellung für ein Cloud-Modell dauert nur einige Sekunden, da dieses nicht heruntergeladen werden muss. Hier ein 'glm-4.7-Modell' welches offenbar mit 327 Milliarden Parametern läuft. Es gibt aktuell vermutlich wenige Anwender, die so ein Modell auf der eigenen Hardware brauchbar zum Laufen bringen.

pp@MacStudio2025 ~ >ollama run glm-4.7:cloud

pulling manifest

pulling 1ccd7f5afbf8: 100% ▕██████████████████▏ 327 B

verifying sha256 digest

writing manifest

success

Connecting to 'glm-4.7' on 'ollama.com' ⚡

>>> Send a message (/? for help)YouTube-Video

Die Installation von Open WebUI habe ich hier vorgestellt:

[OpenRouter] habe ich bisher vor allem mit Goose verwendet, wenn mächtige Modelle für die Programmierung nötig waren:

Im Video wird Open WebUI im Zusammenspiel mit OpenRouter vorgestellt.

Die Zusammenfassung wurde mithilfe von KI‑Tools erstellt. Web Clipper > Obsidian > Copilot, unter lokaler Verwendung von gpt‑oss:120b auf einem Mac Studio.

Weitere Beiträge zum Thema KI:

Zusammenfassung mit dem Obsidian Copilot Plugin und gpt-oss:120b

So erstellst du deinen eigenen KI-Chatbot mit allen KI-Modellen von allen Anbietern

- Vorstellung eines lokalen Chatbots, der alle Modelle aller Anbieter nutzt, inkl. GPT‑5 Pro.

- Schritt‑für‑Schritt Anleitung zur Installation und Konfiguration.

- Ziel: einfache, nicht‑raketenwissenschaftliche Einrichtung.

OpenWebUI als Oberfläche für den Chatbot installieren

- OpenWebUI ist ein Open‑Source‑Projekt, Download über GitHub.

- Dokumentation bietet Quickstart für private Nutzung.

- Admin‑ und Userverwaltung vorhanden, kann aber für Einzelnutzer vereinfacht werden.

Docker verwenden, um OpenWebUI einfach zu installieren

- Empfohlene Installationsmethode: Docker (alternativ Python/Kubernetes).

- Hinweis auf schrittweise Anleitung für Einsteiger.

Docker installieren

- Download von docker.com für macOS, Windows und Linux.

- Installation erfolgt wie jede andere Anwendung.

- Nach dem Start erscheint die Docker‑Oberfläche mit Sign‑In‑Option.

OpenWebUI über das Docker Terminal herunterladen

- Image via

docker pullaus GitHub holen. - Nutzung des integrierten Docker‑Terminals zum Ausführen des Befehls.

- Download kann je nach Verbindung einige Zeit dauern.

OpenWebUI als Docker Container installieren im Single User Modus

- Container starten und im „Single User Mode“ ohne Login betreiben.

- Anpassungen nur nötig, wenn bereits eine Instanz existiert.

- Erfolgreicher Start wird in Docker angezeigt.

Unseren Docker Container ohne Terminal stoppen und starten

- Container kann über die Docker‑GUI gestoppt und gestartet werden.

- Ressourcen des PCs werden bei Stopp freigegeben.

Unsere OpenWebUI Oberfläche im Browser öffnen

- Zugriff über

http://localhost:3000. - Öffnet lokale Weboberfläche, die wie ein normaler Chatbot wirkt.

Übersicht über die OpenWebUI Oberfläche

- Standard‑Chat‑Interface, zunächst nur das „Arena Model“ aktiv.

- Ziel: später alle gewünschten Modelle integrieren.

KI-Modelle über OpenRouter einbinden

- Registrierung bei openrouter.com und API‑Key erstellen.

- API‑Key mit optionalem Ausgabenlimit sichern.

Einen API-Key für OpenRouter erstellen

- Schlüssel im Profil unter „Keys“ erzeugen, Namen und Limit festlegen.

- Schlüssel muss nach Erstellung kopiert werden (einmalig einsehbar).

OpenRouter API in OpenWebUI verknüpfen

- In OpenWebUI Einstellungen → Verbindung → OpenAI‑API neuen Eintrag anlegen.

- API‑Key und Basis‑URL (

https://openrouter.ai/api/v1) eingeben, speichern.

Die neuen Modelle in der Modellauswahl von OpenWebUI

- Nach Verknüpfung erscheinen alle über OpenRouter verfügbaren Modelle.

- Beispiele: GPT‑5 Pro, Gemini 2.5 Pro, Anthropic, XAI usw.

- Auswahl und Test einer Modellantwort im Chat.

Spezielle Funktionen unseres OpenWebUI Chatbots: Mehrere Modelle nutzen, Antworten zusammenführen

- Parallelabfrage mehrerer Modelle möglich.

- Kombinierte Antwort aus den einzelnen Modellausgaben generieren lassen.

- Nutzung kostenloser Modelle über OpenRouter ebenfalls unterstützt.

Verwaltung von Modellen in den Einstellungen

- Modellliste zeigt ca. 343 verfügbare Modelle.

- Modelle umbenennen, Bild hinzufügen, Prompt‑Vorschläge und Wissensdatenbanken definieren.

- Aktivierung/Deaktivierung einzelner Modelle zur Übersichtlichkeit.

Verlauf unserer Unterhaltungen in OpenWebUI

- Chatverlauf wird lokal gespeichert und ist jederzeit einsehbar.

- Nutzung für Kurse und persönliche Projekte möglich.

Kostenkontrolle bei OpenRouter und kostenlose Modelle nutzen

- Credits im OpenRouter‑Konto verwalten, Ausgaben pro Modell nachverfolgen.

- Gratis‑Modelle identifizieren und aktivieren, um Kosten zu vermeiden.

- Vergleich von kostenpflichtigen Top‑Modellen vs. kostenlosen Alternativen.

Unser Fazit zur Kombination aus OpenWebUI und OpenRouter

- Lokale Installation ermöglicht Nutzung aller Top‑Modelle ohne teure Abos.

- Geringe monatliche Kosten trotz intensiver Nutzung.

- Ausblick: mögliche Integration lokaler Modelle in Zukunft.