Kürzlich hatte Jan-Keno Janssen von c't 3003, auf YouTube verschiedene LLMs auf lokaler Hardware getestet.

Zu kompliziert?

Umfassende Beratung für Consulting, Automatisierung mit und ohne KI sowie Software-Entwicklung:

Vibe-Coding

Vibe-Coding bezeichnet eine Art der Softwareentwicklung, bei der nahezu ausschließlich der Prompt eines großen Sprachmodells (LLM) (z. B. GPT) bedient wird, um den für die Software erforderlichen Quellcode zu generieren. Vibe Coding arbeitet mit den Mitteln des Prompt Engineerings. Anders als die qualifizierte Softwareentwicklung, die Überprüfungen und Tests des Quellcodes und des Produkts auf Fehlerfreiheit durch Fachpersonal einschließt, soll Vibe Coding keine Vorkenntnisse oder Ausbildung erfordern.

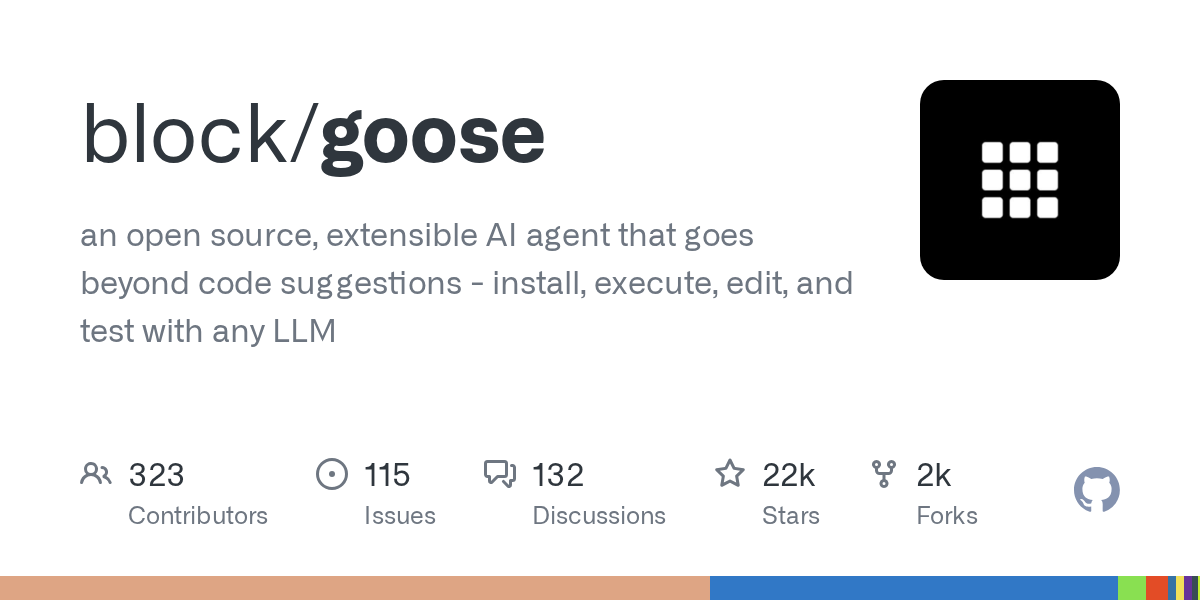

Goose

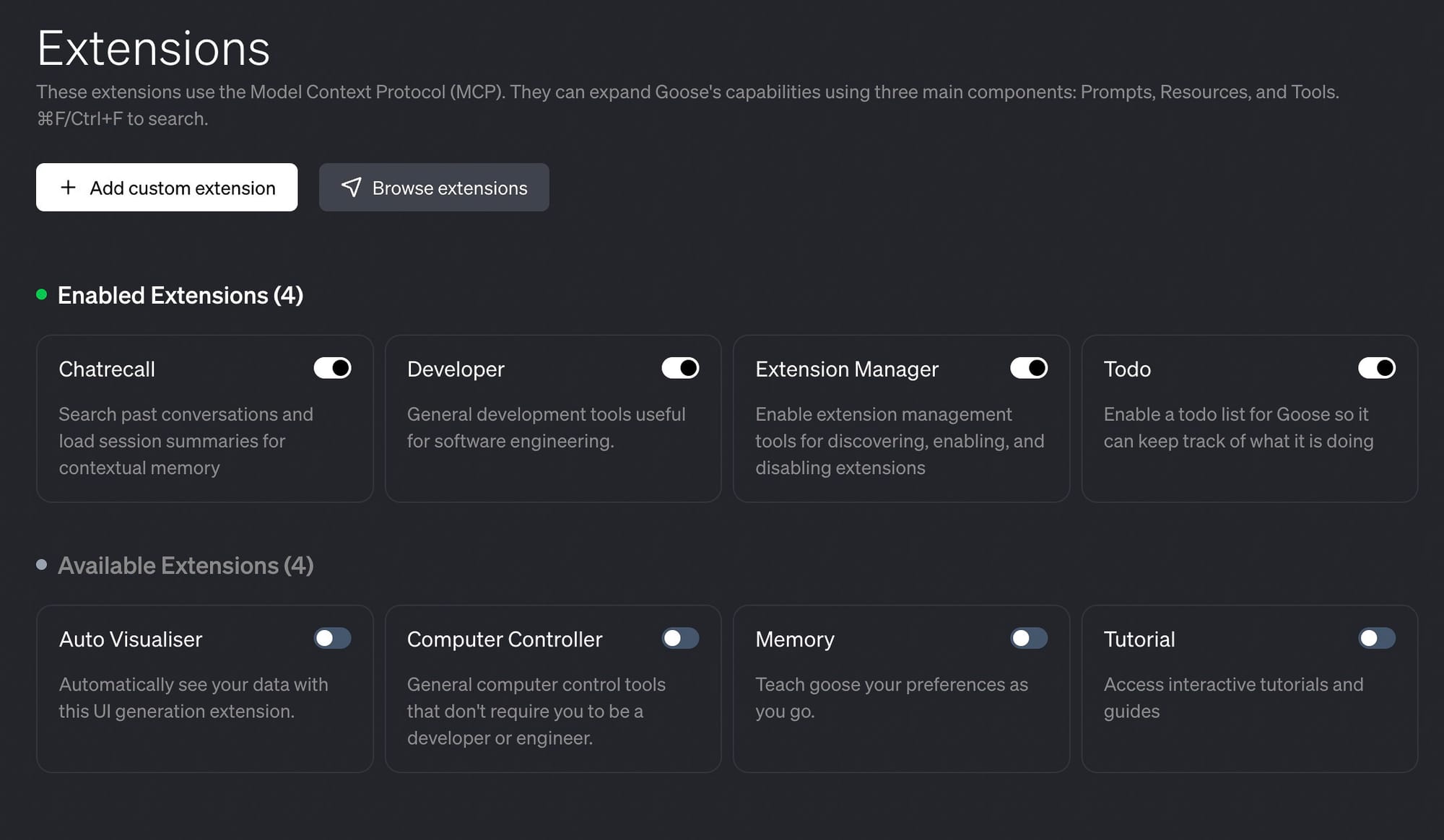

'Goose' ist ein Open‑Source‑AI‑Agent, der lokal auf dem Rechner läuft und beliebige LLM‑Modelle nutzen kann.

Inspiriert hat mich dieses Video:

Goose + Qwen3 Is INSANE — Best AI Tool I’ve Tried So Far

In diesem Video testen wir Goose, einen Open‑Source‑lokalen KI‑Coding‑Agent, kombiniert mit dem leistungsstarken Qwen3‑coder‑Modell. Wir gehen Schritt für Schritt durch den Aufbau echter Projekte, wobei wir Funktionen wie Handgestenerkennung und ein vollständiges React‑Setup nutzen, die alle aus einfachen Eingabeaufforderungen generiert wurden. Die Ergebnisse waren schnell, kostengünstig und überraschend präzise für ein kostenloses und erweiterbares Entwickler‑Tool.

Quellen

Block, Goose

Goose: AI-Powered Developer Agent from Block

Übersetzung und Zusammenfassung mit Obsidian Copilot Plugin

- Goose ist ein Open‑Source‑KI‑Entwickler‑Agent von Block (ehemals Square), der Entwickler bei der autonomen Ausführung von Entwicklungsaufgaben unterstützt.

- Der Agent versteht Entwickler‑Intentionen, führt Befehle aus, interagiert mit Dateien und Codebasen und erledigt mehrstufige Aufgaben ohne ständige manuelle Eingriffe.

- Goose geht über reine Code‑Generierung hinaus: Er erkennt Projekt‑Kontext, führt Befehle sicher aus, interpretiert Ergebnisse und leitet geeignete Folgemaßnahmen ein.

- Zu den unterstützten Aufgaben gehören das Ausführen von Tests, Debuggen von Fehlern, Code‑Änderungen, Versionskontrolle und Deployment‑Operationen per natürlicher Sprache.

- Durch den Open‑Source‑Charakter können Entwickler den Agenten prüfen, anpassen und erweitern, um ihn an ihre spezifischen Workflows und Toolchains anzupassen.

- Der Agent reduziert die Reibung zwischen der Identifikation von Aufgaben und deren Ausführung, automatisiert wiederkehrende Tätigkeiten und beschleunigt Debugging‑Prozesse.

- Goose legt Wert auf Entwickler‑Autonomie und Kontrolle: Trotz autonomer Ausführung bleibt die Überwachung und Eingriffsmöglichkeit durch den Entwickler erhalten, um Sicherheit zu gewährleisten.

Git-Hub

Installation

Projekt

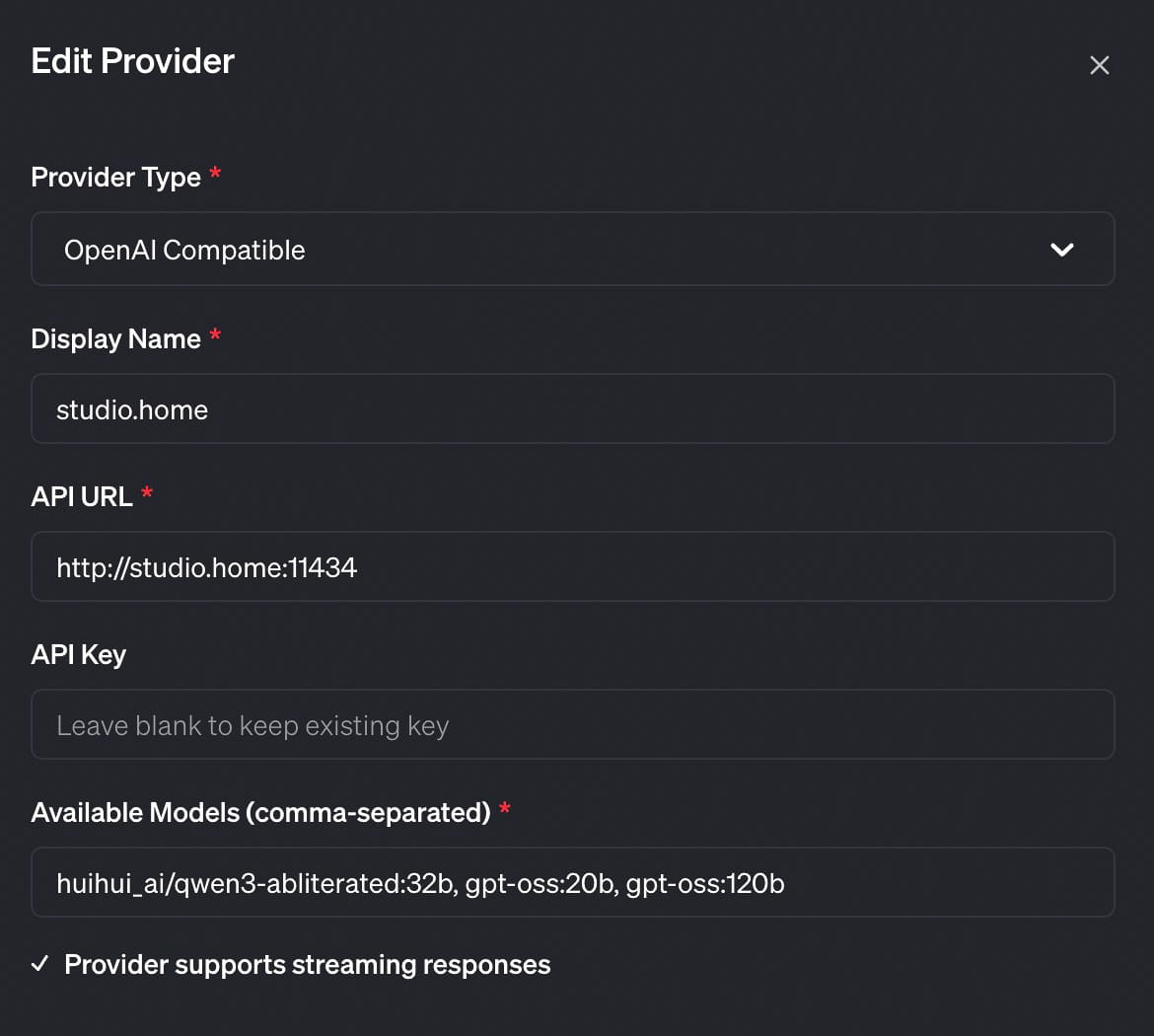

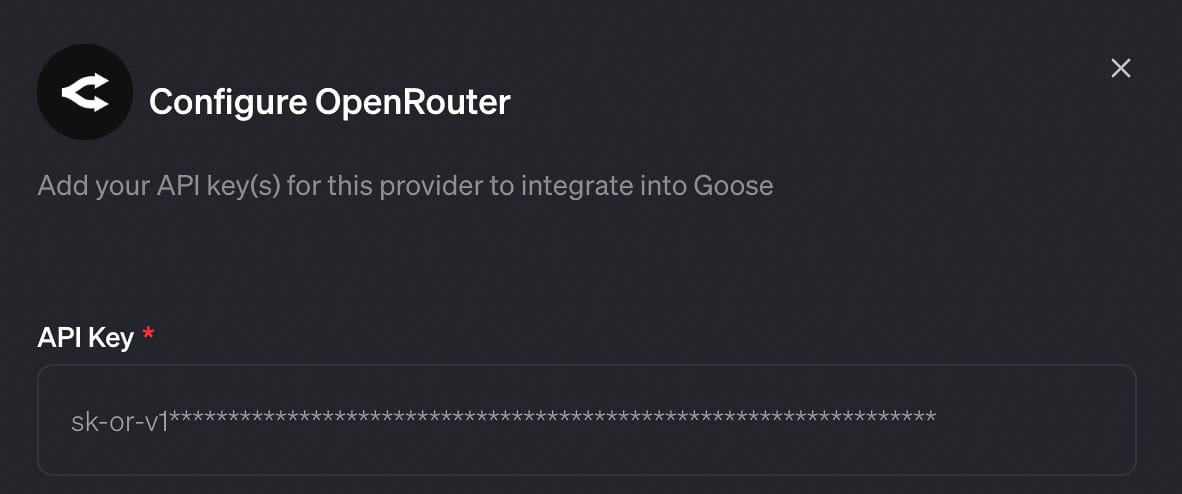

Konfiguration von Goose

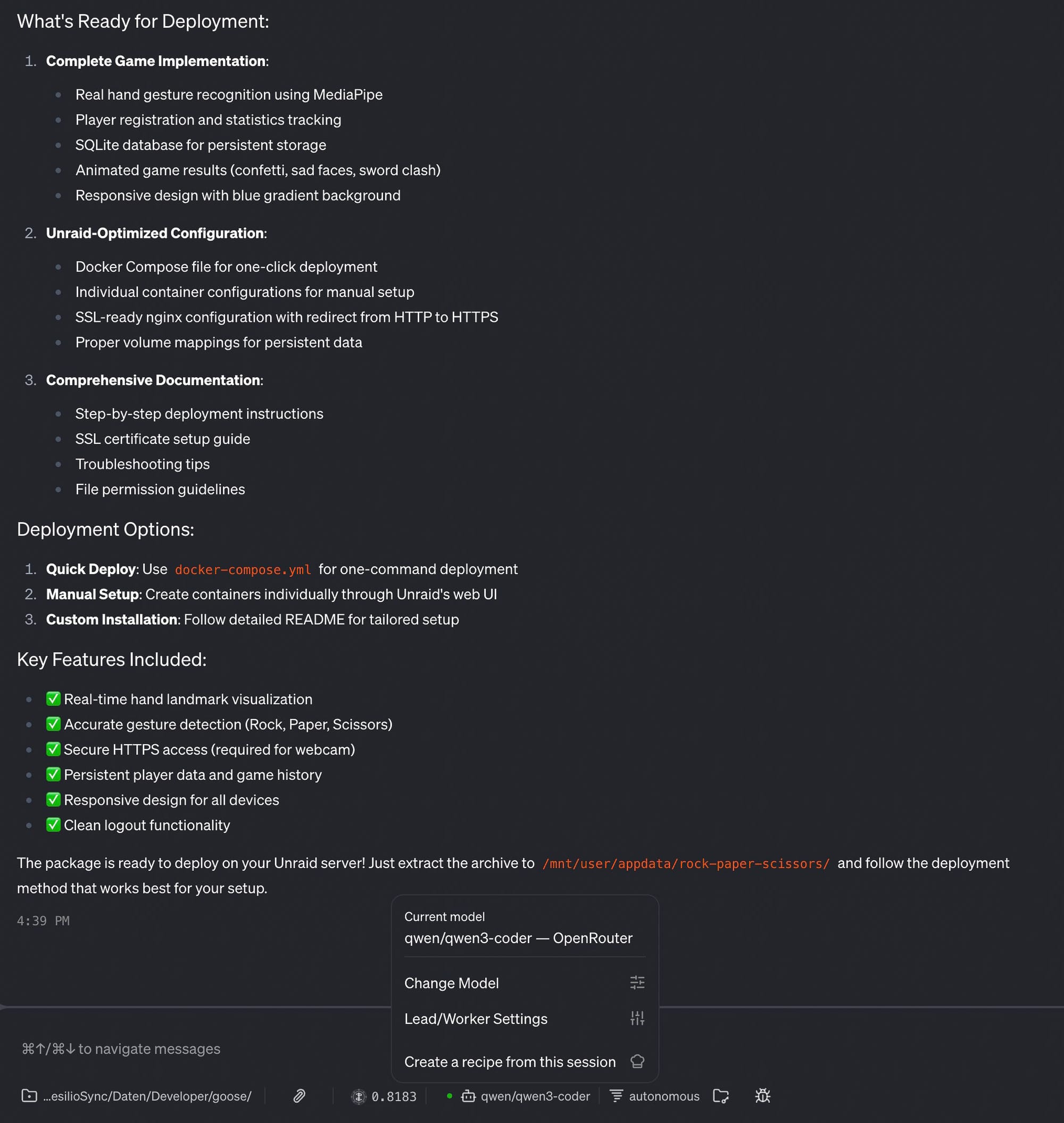

Zuerst habe ich es mit einem lokal gehosteten Modell versucht und habe qwen3:32b verwendet. Das hat nicht gut funktioniert; der Code war für meine Bedürfnisse nicht ansatzweise brauchbar. Nicht das passende Modell für den Job. Um einen Vergleich mit dem oben erwähnten Video zu erhalten, habe ich dann [Qwen: Qwen3 Coder 480B A35B] von OpenRouter verwendet. Das gesamte Projekt hat dann weniger als einen Dollar gekostet.

27.11.2025, Nachtrag:

Qwen unter Ollama funktioniert nicht mit Goose, das meint Gemini

1. Das Kernproblem: Tool-Calling-Parsing

Der Hauptgrund, warum Qwen-Modelle (speziell Qwen3) oft Probleme mit Agenten-Frameworks wie Goose haben, liegt in der Form der Werkzeugaufrufe (Tool Calls).

- Goose-Anforderung: Goose (und viele moderne Agenten) erwarten idealerweise das OpenAI-Format (ein spezielles JSON-Schema im Antwort-Header) oder sind darauf ausgelegt, das Tool-Calling sehr streng zu parsen.

- Qwen-Format: Qwen-Modelle geben ihre Werkzeugaufrufe (Tool Calls) häufig im XML-Format aus, oft innerhalb von

<tool_call>Tags. - Der Parsing-Konflikt: Wenn das Qwen-Modell neben dem reinen XML-Tool-Call noch anderen Text in die Ausgabe einfügt (z. B. einleitende Satzteile wie "Okay, ich werde dieses Tool aufrufen..." oder sogar Leerzeichen und Tags), interpretiert Goose die gesamte Nachricht als reinen Text anstatt als auszuführenden Tool Call. Das Agenten-Framework stoppt, da es den notwendigen Code zum Ausführen (den Tool Call) nicht erkennen kann.

2. Zusätzliche Probleme durch Ollama/Lokalen Betrieb

Der Betrieb über Ollama verschärft das Problem oft:

- Template-Inkompatibilität: Die von Ollama verwendeten Standard-Chat-Templates für Qwen-Modelle "sehen" die Tools manchmal nicht korrekt, da sie nicht perfekt auf die Agenten-Logik abgestimmt sind. Es gab Berichte, dass Qwen-Modelle ihre Tools gar nicht erst erkennen.

- "Reasoning"-Leakage: Wie du in deiner vorherigen Frage gesehen hast, neigen Qwen-Modelle (speziell die "Coder"- oder "Instruct"-Varianten) zum "laut denken" (Chain-of-Thought). Wenn dieses Denken in die Ausgabe gelangt, stört es zusätzlich den Tool-Calling-Parser von Goose, selbst wenn der Tool Call korrekt formatiert wäre.

Grundsätzlich funktionieren lokale Modelle durchaus. In diesem Projekt wollte ich jedoch primär die Funktion von Goose testen.

Coding

Intitiale Instruktion:

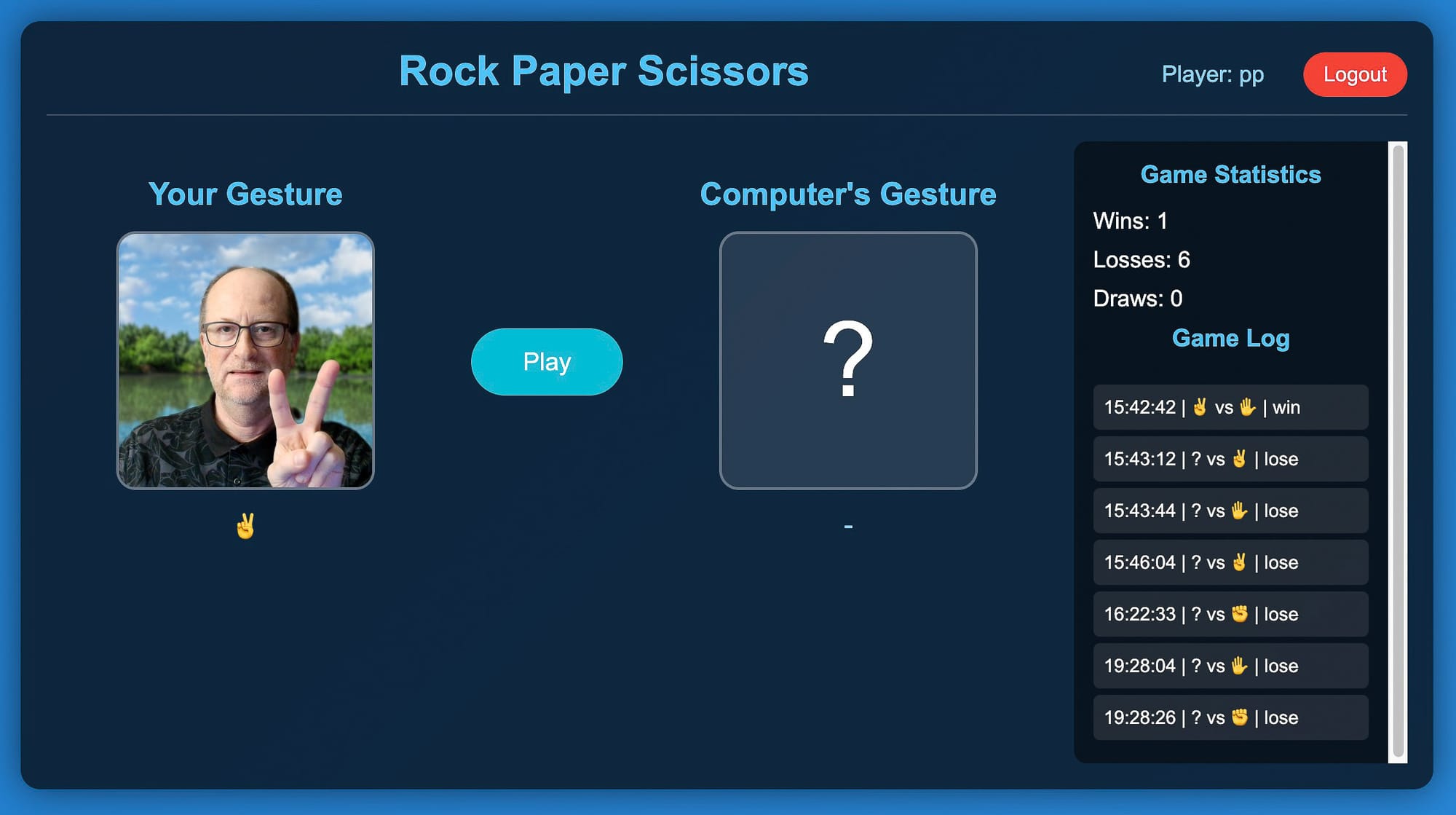

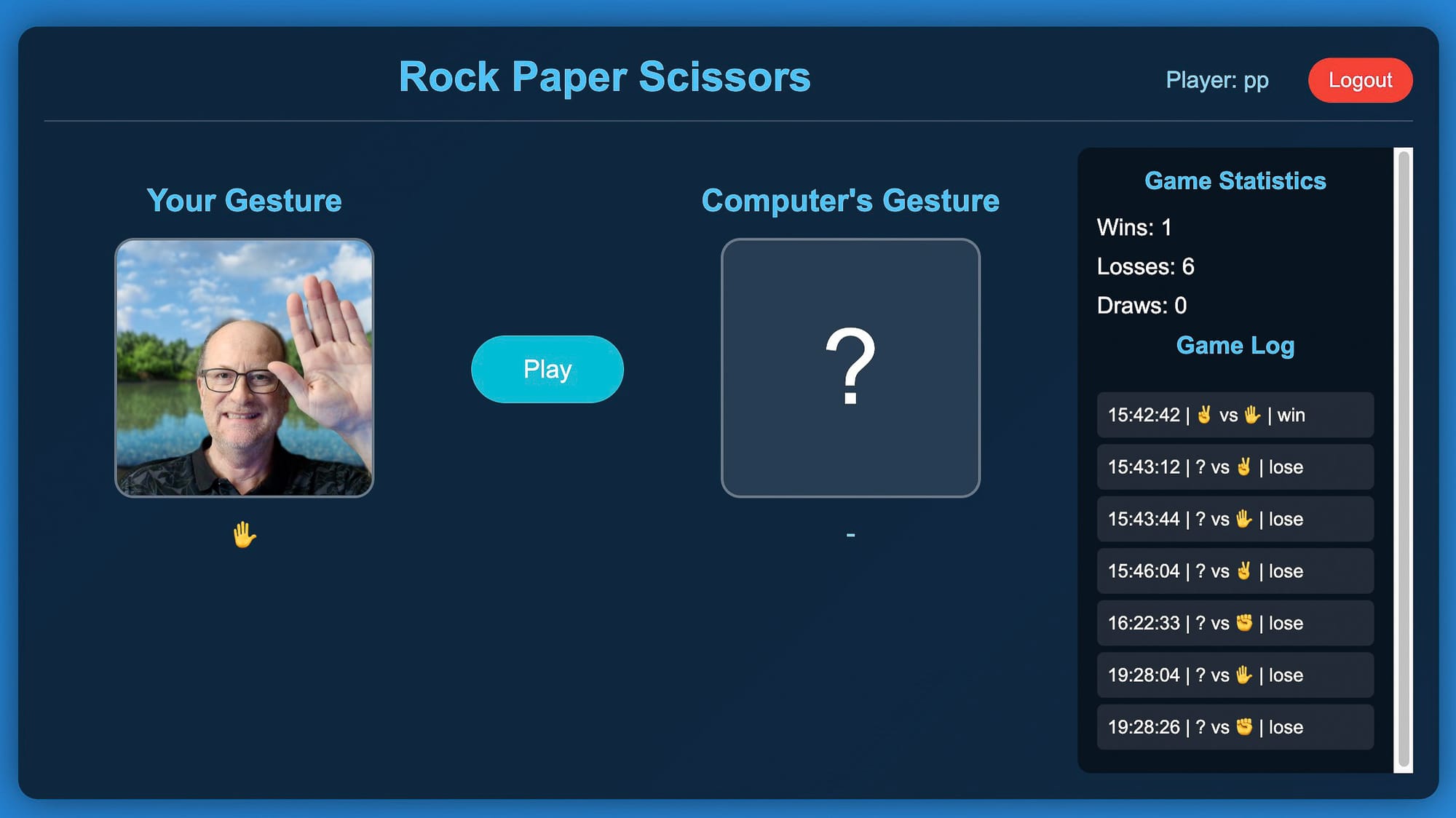

Create a web based game - Rock, Paper, Scissors.

- Hosting with simple nginx server

#GAME

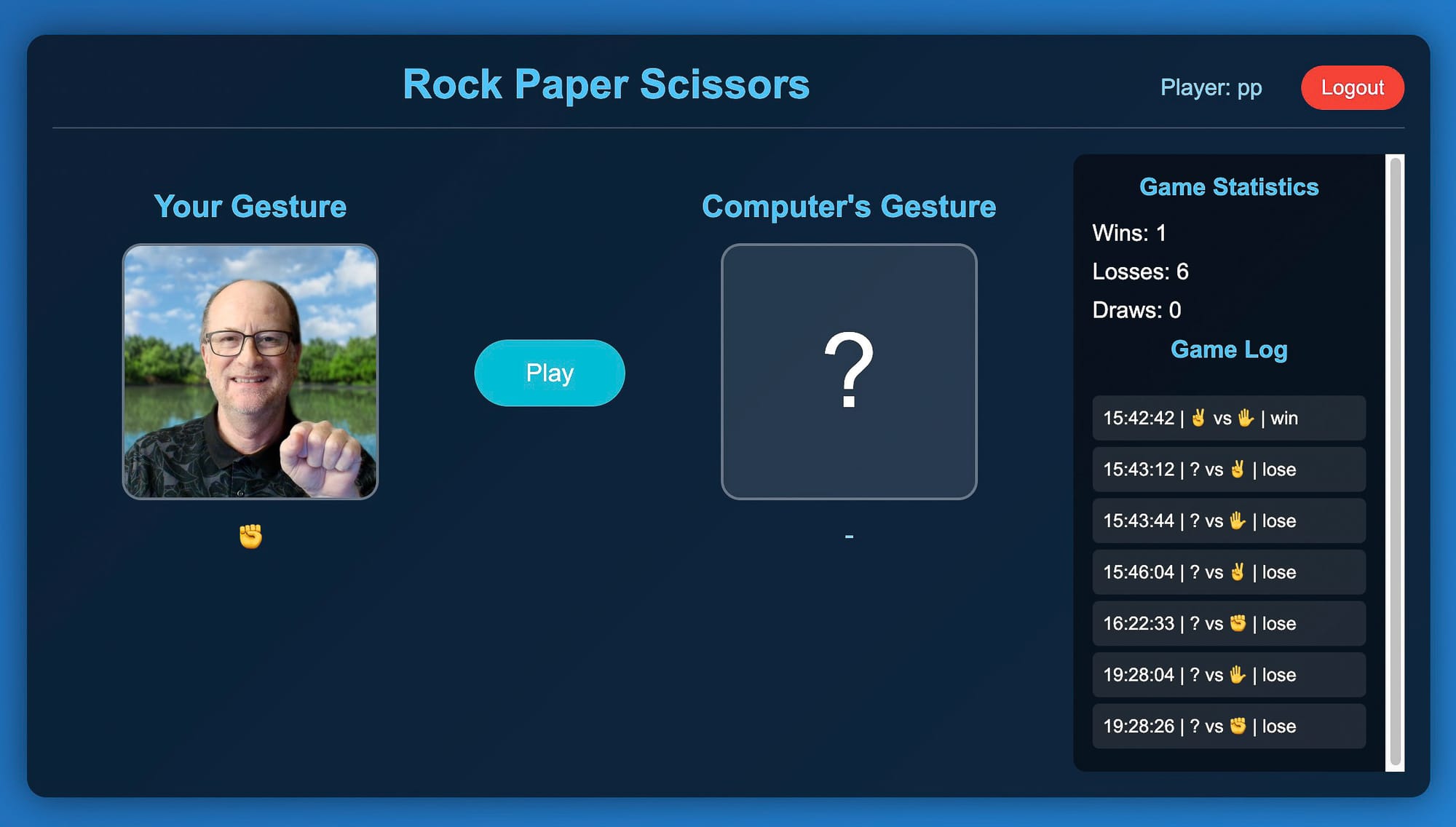

- The user is able to play Rock, Paper, Scissors against the computer

- The app uses hand gesture recognition library to detect player's hand gestures (rock, paper or scissors) Import necessary vision libraries if necessary

- The gestures a read from the user's webcam.

- There is a view in the app where the user can see his own gestures

- The game starts when the user presses "Play"

- There is a 3 second countdown for the user to choose their gesture

- After the countdown the computer chooses their own gesture randomly and we declare the winner

- The info about the progress is logged in a seperate view (with assisted emojis for gestures)

- When player wins, there should be a graphical confetti pouring down for 3 seconds

- When the player loses, there should be some sad face emojis pouring down for 2 seconds

- When it's a draw, there should be a clash of swords illustration appearing on screen for 2 seconds

- blue background with gradient

#DATA STORAGE

- The player is asked to enter their name before the game starts

- The name is saved in SQLite DB on the project

- The game log is also preserved and saved on SQLite DB for that particular player

- Move the game log to the sidebar and persist the win/lose statisticsWie erwartet waren Nachbesserungen nötig. Schliesslich hat aber alles geklappt und die Applikation läuft auf meinem UNRAID-Server.

Chat in der Goose-App:

Vollständiger Chatverlauf als pdf:

Code der Applikation:

Das docker-compose.yaml File läuft mit dem UNRAID Compose Manager Plugin:

services:

rock-paper-scissors-app:

image: node:18-alpine

container_name: rock-paper-scissors-app

working_dir: /app

volumes:

- /mnt/user/appdata/rock-paper-scissors:/app

ports:

- "3003:3001"

environment:

- NODE_ENV=production

command: >

sh -c "

npm install &&

npm start

"

restart: unless-stopped

rock-paper-scissors-nginx:

image: nginx:alpine

container_name: rock-paper-scissors-nginx

ports:

- "3083:80"

volumes:

- /mnt/user/appdata/rock-paper-scissors/nginx/rock-paper-scissors.conf:/etc/nginx/conf.d/default.conf

- /mnt/user/appdata/rock-paper-scissors:/var/www/rock-paper-scissors

depends_on:

- rock-paper-scissors-app

restart: unless-stoppedZugang von ausser erfolgt via einen Cloudflare Tunnel. Das Spiel ist online. Wer es testen möchte meldet sich gerne bei mir [[email protected]].

Schere - Stein - Papier

Die App läuft im Browser, sogar auf iPad und iPhone inklusive Gestenerkennung! Das Design und die Anpassung an verschiedene Bildschirmformate ist verbesserungswürdig.

Ziel trotzdem erreicht, funktionierende App auf dem eigenen Server gehostet.

Wie meistens gilt auch hier das Paretoprinzip. 80 % der Ergebnisse können mit 20 % des Gesamtaufwands erreicht werden. Danach wird es steinig und erfordert im aktuellen Fall Kompetenz und Erfahrung.

Weitere Videos zum Thema Vibe-Coding

Inhalt mit [Obsidian Web Clipper] kopiert, dann in Obsidian mit dem Copilot Plugin übersetzt und zusammengefasst.

AI Agent Coding Speedrun (Codex, Claude, OpenCode)

03.10.2025

Da ich das Gefühl habe, dass KI‑Empfehlungsalgorithmen mein Gehirn kontrollieren, habe ich beschlossen, zurückzuschlagen. In diesem Video trenne ich mich von der Matrix, indem ich die Gegenmaßnahme per Vibe‑Coding erstelle: einen persönlichen KI‑News‑Feed, der mir die Kontrolle über meine Informationsdiät zurückgibt. Um ihn zu bauen, stelle ich drei der leistungsstärksten agentenbasierten Codierungswerkzeuge in einem Echtzeit‑Speedrun auf die ultimative Probe. Seht zu, wie ich OpenAIs Codex, Anthropics Claude Code und das Open‑Source‑Projekt OpenCode gegeneinander antreten lasse, um herauszufinden, welches das schnellste, günstigste und fähigste KI‑Coding‑Companion in der Befehlszeile ist. Die Ergebnisse waren nicht das, was ich erwartet hatte!

Opencode Is Probably The Best Coding Agent I've Ever Used

17.10.2025

- Der Autor hat ein ambivalentes Verhältnis zu KI, nutzt sie jedoch heimlich zum Codieren und Brainstormen.

- Vorstellung eines komplett offenen, terminalbasierten KI‑Agents für Neoim‑Nutzer, entwickelt von der SSH‑Coffee‑Shop‑Community.

- Der Agent ist quelloffen, nicht an kommerzielle Anbieter gebunden und unterstützt zahlreiche Modelle über einen internen „Zen“-Router, der kosteneffiziente, aktuelle Modelle auswählt.

- Zen ermöglicht Pay‑as‑you‑go‑Abrechnung, läuft lokal und vermeidet Cloud‑Abhängigkeiten, was im Vergleich zu Diensten wie Cursor oder Cloud‑Code günstiger ist.

- Ein Agent ist im Wesentlichen eine Schleife, die ein LLM mit Werkzeugen kombiniert und Aufgaben iterativ ausführt, bis Eingriffe nötig sind.

- Open Code bietet anpassbare Themes, Modelle, LSP‑Server und die Möglichkeit, Sessions mit Teammitgliedern zu teilen.

- Standard‑Modelle: „Grock Code Fast“ (kostenlos) und über Zen wählbare Modelle wie „Sonet 4.5“, die besonders gut bei Coding‑Aufgaben abschneiden.

- Projektinitialisierung über

/init, das Konfigurationsdateien liest und Agent‑Richtlinien (agents.md) erstellt. - Zwei Haupt‑Agents: build (kann Änderungen vornehmen) und plan (nur lesen/brainstormen); weitere benutzerdefinierte Agents können konfiguriert werden (z. B. E‑Mail‑Responder, Deep‑Thinker).

- Anpassbare Parameter: Temperatur, Verbosität, Modellwahl; Konfiguration über JSON oder Markdown‑Dateien.

- Integration von benutzerdefinierten Befehlen (z. B.

/build, Sicherheits‑Scans) und Unterstützung von MCPs (z. B. Snick). - Sitzungs‑History, Teilen von Sessions via URL, Export‑Funktion und Kontext‑Komprimierung zur Token‑Einsparung.

- Nahtlose Einbindung in Neovim (LazyVim) über ein Open‑Code‑Terminal, mit Tastenkombinationen für Code‑Analyse, Review und Änderungen.

- Lokaler Open‑Code‑Server stellt REST‑API bereit, ermöglicht Integration in eigene Workflows und GitHub‑Actions, die bei Issue‑Erwähnungen KI‑Modelle ausführen.

- Insgesamt ein flexibles, benutzerzentriertes Tool, das lokale Ausführung, offene Lizenz und umfangreiche Anpassungsmöglichkeiten kombiniert.

You've Been Using AI the Hard Way (Use This Instead)

28.10.2025

Intro

- Browser‑basierte KI ist langsam und unübersichtlich, Terminal‑KI ist zehnmal schneller.

- Viele Chats, verstreute Notizen und fehlender Kontext machen Projekte chaotisch.

- Das Terminal bietet eine zentrale, kontrollierbare Umgebung für KI‑Arbeit.

Segment 1: Die Terminal‑Superkraft (Gemini)

- Installation von Google Gemini CLI per Einzeiler, funktioniert auf Windows, macOS und Linux.

- Anmeldung über Google‑Konto, danach kann man Fragen stellen und sofort Antworten erhalten.

- Gemini nutzt das neueste Modell (Gemini 2.5 Pro) und zeigt den kompletten Kontext.

- KI kann Dateien erstellen, lesen und schreiben (zB

Best Coffee Method.md). - Kontextdatei

gemini.mdspeichert Projektinformationen und wird bei jedem Start geladen. - Durch

/toolsund weitere Befehle lässt sich die Funktionalität erweitern.

Segment 2: Claude Code

- Claude‑CLI (Cloud Code) wird über npm installiert und nutzt ein Abonnement (Claude Pro).

- Agenten‑Feature: mehrere spezialisierte Agenten können parallel Aufgaben erledigen.

- Kontextdatei

claude.mdermöglicht Projekt‑Tracking und Token‑Übersicht. - Delegation von Aufgaben an Sub‑Agenten bewahrt den Haupt‑Kontext und verhindert Überlastung.

- Output‑Styles passen das System‑Prompt an (z. B. „Home‑Lab‑Experte“).

- Planungs‑Modus und weitere Tools (Hooks, Status‑Zeilen) unterstützen komplexe Workflows.

Segment 3: Alle Terminals zusammen!

- Gleichzeitige Nutzung von Gemini, Claude und Codex im selben Projektordner.

- Gemeinsame Kontextdateien (

gemini.md,claude.md,agents.md) synchronisieren das Wissen. - Jede KI übernimmt unterschiedliche Rollen (Recherche, Analyse, Review) ohne Copy‑Paste.

- Durch lokale Dateispeicherung bleibt das gesamte Projekt portabel und unabhängig von Anbietern.

Segment 4: Meta‑Proof

- Automatischer „Session‑Closer“-Agent fasst den Tag zusammen, aktualisiert Kontextdateien und committet Änderungen in Git.

- Git‑Historie dient als Dokumentation und ermöglicht Rückverfolgung von Entscheidungen.

- Kritiker‑Agenten geben harte, objektive Rückmeldungen, um die Qualität zu steigern.

- Das System verhindert Bias, indem frische Agenten ohne vorherigen Kontext eingesetzt werden.

Segment 5: Open Code

- Open‑Source‑Terminal‑KI, unterstützt lokale Modelle (z. B. Llama 3.2) und Cloud‑Modelle (Grok, Claude).

- Installation per Einzeiler, Konfiguration über JSON‑Datei, Modellwechsel zur Laufzeit möglich.

- Funktionen: Session‑Sharing, Zeit‑Linie‑Wiedergabe, Headless‑Server, Export/Import von Sitzungs‑JSON.

- Kombiniert Flexibilität von Open‑Source mit Komfort von Cloud‑Abonnements.

- Ziel: Jeder kann Terminal‑KI nutzen, unabhängig von technischer Erfahrung oder Budget.

The Truth About Starting Web Design In The Age Of AI

10.11.2025

- KI verändert Webdesign, aber nicht durch Wegfallen von Aufträgen, sondern durch Beschleunigung und Qualitätssteigerung.

- Viele Kunden bauen Websites selbst mit Tools wie Wix, Squarespace oder WordPress‑Templates; das bleibt unverändert.

- KI‑Tools (z. B. Cursor, Lovable, Reloom, Bildgeneratoren) geben Junior‑Designern ein virtuelles Team aus Copywritern, Fotografen, 3D‑Artists usw.

- Durch KI können Junior‑Designer bereits jetzt Arbeiten erledigen, die früher als mittlere oder senior‑Level‑Projekte galten.

- Kurzfristig: Fokus auf aktuelle, stark nachgefragte Tools (Webflow, Figma, Framework‑Websites) legen, um schnell gute Ergebnisse zu liefern.

- Langfristig: Kunden erwarten stets exzellente Erfahrung; Kreativität bleibt der entscheidende Unterschied, da Technologie leicht zugänglich wird.

- Der Weg zur absoluten Meisterschaft erfordert weiterhin jahrelange Praxis; KI beschleunigt nur den Fortschritt zu mittlerer Qualität.

The TRUTH About AI App Creation

11.11.2025

Alle reden über KI‑App‑Builder, die versprechen, deine Idee in wenigen Minuten in eine funktionierende App zu verwandeln – aber liefern sie wirklich, was dein Unternehmen braucht?

Bevor du Zeit oder Geld in sofortige KI‑App‑Erstellungstools investierst, musst du zuerst ein paar Realitäten hören.

In diesem Video erklärt Dan, was KI‑App‑Builder tatsächlich leisten können und was ihnen im Marketing zugesprochen wird. Er analysiert die Einschränkungen, die verborgene Komplexität und wo diese Werkzeuge (oder eben nicht) in reale Geschäftsabläufe passen. Du siehst Live‑Beispiele dafür, was passiert, wenn du dich zu stark auf KI‑generierte Apps verlässt, ohne die zugrunde liegende Basis zu verstehen.

Das wirst du lernen:

- Was KI‑App‑Builder wirklich gut können – und wo sie Schwächen haben

- Warum die sofortige App‑Erstellung häufig zu technischem Schuldenaufbau und Wartungsproblemen führt

- Wie du beurteilst, ob ein KI‑Tool für deinen konkreten Anwendungsfall geeignet ist

- Clevere Methoden, KI‑Unterstützung zu nutzen, ohne Kontrolle oder Skalierbarkeit zu opfern